Виртуальный коммутатор open vswitch: обзор возможностей

Содержание:

- Введение

- Постановка задачи

- What is Open vSwitch?

- OpenVswitch DPDK to KVM Guests

- Sample Topology¶

- Talks, Session 2

- MidoNet and the Open vSwitch Datapath (Duarte Nunes, Midokura)

- Mininet and Open vSwitch (Bob Lantz, ON.Lab)

- OVS and L7 classification (DPI) use cases and demos: L7 stateful firewall, L7 QoS, L7 service chaining (Franck Baudin, Qosmos)

- Implementing OpenFlow on a hardware switch (Tony van der Peet, Allied Telesis)

- Настройка openvswitch из etcnet[править]

- Summary¶

- Примеры[править]

- Support and Troubleshooting

- Предварительные настройки

- Talks, Session 3

- Untangle complex network setups (Rashid Khan and Jiri Benc, Red Hat)

- New OVS instrumentation features aimed at real-time monitoring of virtual networks (Peter Phaal, InMon)

- A Proposal for Using TC Classification with Open vSwitch (Simon Horman, Netronome)

- The State of Stateful Services (Joe Stringer and Jarno Rajahalme, VMware)

- Другие нюансы

- libnx bindings

- Постановка задачи

- Подключение к LAN-play

- Flow Control

- Debugging

- Итак, что же мы получим в итоге?

Введение

Без качественных управляемых коммутаторов просто невозможно наладить правильную работу крупной сети и добиться оптимальной пропускной способности и взаимодействия между ее элементами. Хороший коммутатор предоставляет такие необходимые возможности, как организация виртуальных сетей (VLAN), QoS, агрегация каналов, зеркалирование трафика и даже функции брандмауэра. Настолько же важную роль коммутаторы играют и в виртуальных сетях, однако до недавнего времени решения, реализующие программные коммутаторы, предлагали только коммерческие организации, которые просили за них немалые деньги. За тот же Cisco Nexus 1000V для систем VMware vSphere приходилось отдавать около тысячи долларов, что пустяк в сравнении с остальными расходами на сетевую инфраструктуру, но, тем не менее, дополнительная трата средств. Вдобавок это привязка к другому коммерческому решению, за которое придется отдать еще больше. Сегодня, когда полностью открытые решения на базе KVM и Xen уже достигли того уровня развития, при котором они могут составить конкуренцию коммерческим продуктам виртуализации, нам нужен такой же открытый коммутатор, не привязанный к коммерческим решениям.

К счастью, такой продукт есть, и носит он имя Open vSwitch. Это многоуровневый коммутатор с открытым исходным кодом, разрабатываемый совместными усилиями Citrix, Red Hat, Canonical, Oracle и других компаний (в команде разработчиков есть даже человек из FreeBSD Foundation). Open vSwitch может работать как на уровне ядра, так и в пространстве пользователя, предлагая следующие возможности:

- поддержка протоколов NetFlow, sFlow, SPAN и RSPAN;

- поддержка VLAN (IEEE 802.1Q);

- механизм QoS;

- возможность агрегации портов с распределением нагрузки;

- GRE-туннелирование;

- совместимость с программным мостом Linux Bridge (brctl);

- индивидуальные политики для виртуальных машин.

Коммутатор имеет распределенный дизайн, позволяющий установить компоненты системы на множество физических машин и управлять общей виртуальной сетью, используя протокол OpenFlow, другими словами — используя любой совместимый с этим протоколом интерфейс удаленного управления коммутаторами.

Как работает OpenFlow

Сегодня мы рассмотрим, как установить и начать использовать Open vSwitch на одной физической машине с несколькими виртуальными гостевыми окружениями. Рассказ об установке и настройке крупной сетевой инфраструктуры потребовал бы гораздо более объемной статьи, поэтому нижеследующий текст можно считать неким введением в технологию и точкой, от которой можно оттолкнуться для дальнейшего ее изучения.

Постановка задачи

Клиент хочет объединить несколько арендуемых серверов в одну сеть, чтобы избавиться от необходимости платить за несколько дополнительных подсетей, повесить все свое хозяйство за роутер, назначить им внутри локальные адреса, и защититься файрволом. Дабы весь служебный трафик бегал внутри VLAN. Плюс перевезти виртуалочки с одного старого сервера на новый и от того отказаться, проапгрейдить используемое старое железо и заодно переехать на свежий Proxmox.

Изначально у клиента 5 серверов, на каждом по дополнительной подсети, первый адрес из выделенной подсети назначен на дополнительный бридж на Proxmox

При этом VM работают на Windows и у них настроен адрес 85.x.x.177/29 с гейтом 85.x.x.176

И в похожем ключе настроены все 5 серверов со своими виртуальными машинами.

Забавно, что данная конфигурация ошибочна в настройке сети в принципе, использовать адрес сети для первого узла и он же для шлюза. Если такую конфигурацию попробовать завести на виртуальной машине в Ubuntu – сеть не работает.

What is Open vSwitch?

Open vSwitch is a multilayer software switch licensed under the open source

Apache 2 license. Our goal is to implement a production quality switch

platform that supports standard management interfaces and opens the forwarding

functions to programmatic extension and control.

Open vSwitch is well suited to function as a virtual switch in VM environments.

In addition to exposing standard control and visibility interfaces to the

virtual networking layer, it was designed to support distribution across

multiple physical servers. Open vSwitch supports multiple Linux-based

virtualization technologies including Xen/XenServer, KVM, and VirtualBox.

The bulk of the code is written in platform-independent C and is easily ported

to other environments. The current release of Open vSwitch supports the

following features:

- Standard 802.1Q VLAN model with trunk and access ports

- NIC bonding with or without LACP on upstream switch

- NetFlow, sFlow(R), and mirroring for increased visibility

- QoS (Quality of Service) configuration, plus policing

- Geneve, GRE, VXLAN, STT, and LISP tunneling

- 802.1ag connectivity fault management

- OpenFlow 1.0 plus numerous extensions

- Transactional configuration database with C and Python bindings

- High-performance forwarding using a Linux kernel module

The included Linux kernel module supports Linux 3.10 and up.

Open vSwitch can also operate entirely in userspace without assistance from

a kernel module. This userspace implementation should be easier to port than

the kernel-based switch. OVS in userspace can access Linux or DPDK devices.

Note Open vSwitch with userspace datapath and non DPDK devices is considered

experimental and comes with a cost in performance.

OpenVswitch DPDK to KVM Guests

If you are not building some sort of SDN switch or NFV on top of DPDK it is very likely that you want to forward traffic to KVM guests. The good news is, that with the new qemu/libvirt/dpdk/openvswitch versions in Ubuntu this is no more about manually appending commandline string. This chapter covers a basic configuration how to connect a KVM guest to a OpenVswitch-DPDK instance.

The recommended way to get to a KVM guest is using .

This will cause OVS-DPDK to create connect to a socket that qemu created. That way old issues like guest failures on OVS restart are avoided. Here an example how to add such a port to the bridge you created above.

This will connect to the specified path that has to be created by a guest listening on it.

To let libvirt/kvm consume this socket and create a guest virtio network device for it add a snippet like this to your guest definition as the network definition.

Sample Topology¶

This tutorial uses the following topology to carry out the tests.

+ +

| |

| +-----+ |

| | | |

| | | |

| +----------+ | OVS | +----------+ |

| | left | | | | right | |

| | namespace| | | |namespace | |

+-----+ A +------+ +-----+ B +--------+

| | | A'| | B' | | |

| | | | | | | |

| +----------+ | | +----------+ |

| | | |

| | | |

| | | |

| +-----+ |

| |

| |

+ +

192.168.X nw 10.0.X nw

A = veth_l1

A' = veth_l0

B = veth_r1

B' = veth_r0

Diagram Sample Topology for conntrack testing

The steps for creation of the setup are mentioned below.

Create “left” network namespace:

$ ip netns add left

Create “right” network namespace:

$ ip netns add right

Create first pair of veth interfaces:

$ ip link add veth_l0 type veth peer name veth_l1

Add veth_l1 to “left” network namespace:

$ ip link set veth_l1 netns left

Create second pair of veth interfaces:

$ ip link add veth_r0 type veth peer name veth_r1

Add veth_r1 to “right” network namespace:

$ ip link set veth_r1 netns right

Create a bridge br0:

$ ovs-vsctl add-br br0

Add veth_l0 and veth_r0 to br0:

$ ovs-vsctl add-port br0 veth_l0 $ ovs-vsctl add-port br0 veth_r0

Talks, Session 2

MidoNet and the Open vSwitch Datapath (Duarte Nunes, Midokura)

MidoNet, an open source virtual network platform, uses the

Open vSwitch kernel module as it’s datapath, relying on it not only

for packet switching and decision caching, but also as an efficient

way to implement features like flow tracing and congestion analysis.

In this talk we’ll go over the basics of how MidoNet interacts with

the kernel module and manages installed flows. We’ll cover how

mechanisms such as megaflows and connection tracking are leveraged

to power some of MidoNet’s features. Finally, we’ll also present

some performance considerations stemming from the ways the datapath

is employed.

Mininet and Open vSwitch (Bob Lantz, ON.Lab)

Mininet is an emulation framework that quickly creates virtual

networks of hosts, switches, and SDN controllers on your laptop for

development, research, teaching, or any other use. For scalability,

Mininet hosts are usually just processes in network namespaces,

connected to software switches (typically Open vSwitch) via virtual

Ethernet links.

In this talk, I will provide a brief overview and demonstration of

Mininet, describe how it uses Open vSwitch, and present some

experiences so far and thoughts on how OVS might evolve to support

the use case of network emulation.

OVS and L7 classification (DPI) use cases and demos: L7 stateful

firewall, L7 QoS, L7 service chaining (Franck Baudin, Qosmos)

L7 classification with OVS without patch is now possible thanks to

conntrack framework and well-crafted OVS rules. The basic idea is to

rely on a userland L7 classifier, typically based on a DPI engine,

marking the conntracks with L7 classification. Thanks to the new

connmark and connlabel matchers, holding the L7 classification

thanks to the L7 application mentioned previously, we can craft L7

OVS rules.

This presentation will explains and demonstrate the asynchronous

design of L7 classification in two basic use cases:

- QoS: BitTorrent rate limiting, ftp rate limiting

- L7 Firewall: BitTorrent denial, ssh on non-regular ports denial

For the demo part, one client VM and one server VM will be

interconnected by OVS, with L7 rules applied on the server port

(typical micro-segmentation use case). There will be neither OpenStack

nor OpenDayLight for this part, just KVM/virsh/namespaces and

OVS.

The second part of the talk will demonstrate, on the same laptop,

with the same OVS, a service chaining use case with VMs managed by

OpenStack Kilo (vanilla, no patch) and Service Chaining managed by

OpenDayLight Lithium (vanilla, no patch). The rationales of the

technical choices will be explained: why no NSH, what about an NFV

use case with DPDK OVS, what about using OVS as a ServiceClassifier

and/or as a ServiceFunctionForwarder, what about a real NFV

deployment ingredients, …

Implementing OpenFlow on a hardware switch (Tony van der

Peet, Allied Telesis)

I will share my experience of implementing OpenFlow on a hardware

switch, using Open vSwitch, and describe the main lessons

learned. Then I will discuss future plans, involving TTPs, a new

ofproto and OF-DPA.

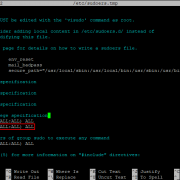

Настройка openvswitch из etcnet[править]

OVS сложная система. Имеет собственную базу данных, где хранит настройки. И не все эти порты и бриджи могут отражаться в системе как сетевые интерфейсы. В связи с чем создавать интерфейс (папку в /etc/net/ifaces) для такого типа порта нет смысла, т.к. etcnet оперирует реальными интерфейсами. Поэтому управлять будем только теми ресурсами которые реально отражаются в системе как сетевые интерфейсы.

Это 3 типа интерфейсов: бридж реальный и фейковый (ovsbr), порт типа internal (ovsport) и специальный тип порта — бондинг (ovsbond).

Реальный и фейковый бридж по сути имеют один тип ovsbr и отличаются только наличием родительского бриджа и влана.

Порт типа не internal это или существующий реальный интерфейс (eth0) или не отраженные в операционной системе интерфейсы (нпример gre, veth). Поэтому я не выделяю их для etcnet. Все это должно настраиваться через OVS_EXTRA.

Бриджправить

Для создания этого типа в options должно быть:

TYPE=ovsbr

Также как опция может быть указан список сетевых интерфейсов, которые должны быть добавлены в данный бридж. Они будут запущены и добавлены в бридж.

HOST='eth2'

NB! Нельзя сюда писать порты OVS (тип ovsport или ovsbond). Они должны быть описаны отдельно, т.к. для их добавления требуется уже существующий бридж.

В результате будет создан бридж. Проверить можно командой

#ovs-vsctl show

BRIDGE=br0 VID=105

И тогда будет создаваться фейковый бридж

Порт типа internalправить

Для его создания в options должно быть:

TYPE=ovsport

Бридж в который должен этот порт добавиться:

BRIDGE=br0

В результате получится сетевой интерфейс который может управляться через утилиту ip и др.

Порт бондингправить

Специальный тип порта для объединения 2х физических сетевых интерфейса в один.

Для его создания в options должно быть

TYPE=ovsbond

Бридж в который должен этот порт добавиться:

BRIDGE=br0

Также должны быть указаны не меньше 2х сетевых интерфейсов, которые должны быть добавлены в данный порт.

HOST='eth1 eth2'

Общие настройки для всех типовправить

Для задания всех остальных всевозможных настроек, должны использоваться переменные:

OVS_REMOVE Если установлено в yes, то при отключении интерфейса, данный порт будет удален из базы данных OVS

Осторожно, т.к. некоторые параметры, например MAC будет сгенерирован заново.

OVS_OPTIONS параметры которые должны быть переданы для настройки данного бриджа или порта

Возможные поля для бриджа можно посмотреть командой:

# ovs-vsctl list bridge

_uuid : 6aac9201-4272-41cc-a7be-1a36e00f6748

controller : []

datapath_id : "000078e7d17fcf13"

datapath_type : ""

external_ids : {}

fail_mode : []

flood_vlans : []

flow_tables : {}

ipfix : []

mirrors : []

name : "ovsbr0"

netflow : []

other_config : {}

ports :

protocols : []

sflow : []

status : {}

stp_enable : false

Тогда если мы хотим включить STP, нужно написать:

OVS_OPTIONS='stp_enable=yes'

Для порта можно посмотреть командой:

# ovs-vsctl list port

_uuid : 58a10ab2-f344-46f9-a313-104c23ba2a8b

bond_downdelay : 0

bond_fake_iface : false

bond_mode : []

bond_updelay : 0

external_ids : {}

fake_bridge : false

interfaces :

lacp : []

mac : []

name : "ovsport0"

other_config : {}

qos : []

statistics : {}

status : {}

tag : []

trunks : []

vlan_mode : []

Если нужно настраивать дополнительно другие интерфейсы или параметры, то это делать нужно через Database Commands (см. соответствующую секцию в ovs-vsctl(8)) Это все указывается в OVS_EXTRA

Например влан, тип и т.д.

OVS_EXTRA='set port eth0 tag=10 -- set port eth1 trunk="1,2,15" '

Данные переменные действуют для всех типов сетевых интерфейсов ovs*.

Summary¶

Following table summarizes the TCP segments exchanged against the flow

match fields

Note: Relative sequence number and acknowledgement numbers are shown as

captured from tshark.

Flows

(flow #1)

$ ovs-ofctl add-flow br0 \

"table=0, priority=50, ct_state=-trk, tcp, in_port=veth_l0, actions=ct(table=0)"

(flow #2)

$ ovs-ofctl add-flow br0 \

"table=0, priority=50, ct_state=+trk+new, tcp, in_port=veth_l0, actions=ct(commit),veth_r0"

(flow #3)

$ ovs-ofctl add-flow br0 \

"table=0, priority=50, ct_state=-trk, tcp, in_port=veth_r0, actions=ct(table=0)"

(flow #4)

$ ovs-ofctl add-flow br0 \

"table=0, priority=50, ct_state=+trk+est, tcp, in_port=veth_r0, actions=veth_l0"

(flow #5)

$ ovs-ofctl add-flow br0 \

"table=0, priority=50, ct_state=+trk+est, tcp, in_port=veth_l0, actions=veth_r0"

Примеры[править]

Простая настройка:

$ cat ens18/options

TYPE=eth

CONFIG_WIRELESS=no

BOOTPROTO=static

CONFIG_IPV4=yes

$ cat vmbr0/options

TYPE=ovsbr

CONFIG_WIRELESS=no

BOOTPROTO=static

CONFIG_IPV4=yes

ON_BOOT=yes

HOST="ens18"

# ovs-vsctl show

6669027e-d2a5-4f23-8d36-bf279d39355c

Bridge "vmbr0"

Port "vmbr0"

Interface "vmbr0"

type: internal

Port "ens18"

Interface "ens18"

ovs_version: "2.11.1"

Настройка VLAN (добавляется к предыдущим):

# cat vlan495/options

TYPE=ovsport

CONFIG_WIRELESS=no

BOOTPROTO=static

CONFIG_IPV4=yes

BRIDGE=vmbr0

OVS_EXTRA="set port vlan495 tag=495"

# cat vlan666/options

TYPE=ovsport

CONFIG_WIRELESS=no

BOOTPROTO=static

CONFIG_IPV4=yes

BRIDGE=vmbr0

OVS_EXTRA="set port vlan666 tag=666"

# ovs-vsctl show

6669027e-d2a5-4f23-8d36-bf279d39355c

Bridge "vmbr0"

Port "vmbr0"

Interface "vmbr0"

type: internal

Port "ens18"

Interface "ens18"

Port "vlan495"

tag : 495

Interface "vlan495"

type: internal

Port "vlan666"

tag : 666

Interface "vlan666"

type: internal

ovs_version: "2.11.1"

Support and Troubleshooting

DPDK is a fast evolving project. In any case of a search for support and further guides it is highly recommended to first check if they apply to the current version.

Check if it is a known issue on:

- DPDK Mailing Lists

- For OpenVswitch-DPDK OpenStack Mailing Lists

- Known issues in DPDK Launchpad Area

- Join the IRC channels #DPDK or #openvswitch on freenode.

Issues are often due to missing small details in the general setup. Later on, these missing details cause problems which can be hard to track down to their root cause. A common case seems to be the “could not open network device dpdk0 (No such device)” issue. This occurs rather late when setting up a port in Open vSwitch with DPDK. But the root cause most of the time is very early in the setup and initialization. Here an example how a proper initialization of a device looks — this can be found in the syslog/journal when starting Open vSwitch with DPDK enabled.

If this is missing, either by ignored cards, failed initialization or other reasons, later on there will be no DPDK device to refer to. Unfortunately the logging is spread across syslog/journal and the openvswitch log. To allow some cross checking here an example what can be found in these logs, relative to the entered command.

Предварительные настройки

Часть I — Настраиваем клиент

- Скачайте и установите драйвера WinPCap

- Скачайте свежую версию Lan-Play-Server-Manager и распакуйте её на ПК

- Распакуйте архив в удобную папку

- Запустите от имени Администратора

- Снимите галочку с пункта “Fake Internet”

- Выберите нужный сервер из представленных в списке и нажмите “Подключиться”

- Договоритесь с другими игроками в Discord на каком сервере вы будете играть

- Если подключение установлено, кнопка станет зелёной и сменит название

Часть II — Настраиваем Switch

- Обновите

kefirпо инструкции из репозитория, если не делали этого ранее

- Включите приставку и перейдите в “Системные настройки” -> “Интернет” -> “Интернет-настройки”

- Выберите ваше текущее подключение, нажмите на нём (A) и выберите “Изменить настройки”

- Выберите пункт “Настройки IP-адреса” -> “Ручной ввод”

- Введите статический IP-адрес в диапазоне от до (кроме )

- Значение поля “Маска подсети” установите в

- Значение поля “Шлюз” установите в

- Выберите “Настройки DNS” -> “Ручной ввод”

- В поле “Первичный DNS” введите

- В поле “Вторичный DNS” введите и нажмите “Сохранить”, а затем OK

- Если вы используете , откройте меню SX OS (альбомы) и во вкладке “Options” активируйте “Internet Local Wireless Play

Необходимо активировать заново после каждой перезагрузки приставки

”

Talks, Session 3

Untangle complex network setups (Rashid Khan and Jiri Benc,

Red Hat)

While debugging networking related problems on modern cloud and

container based solutions, one often finds oneself trapped in a maze

of Open vSwitch bridges combined with regular bridges, tunnels, veth

pairs and network namespaces with tens or hundreds of network

interfaces. The relationship between those is usually anything but

clear.

The talk will present plotnetcfg, an open source tool to visually

represent relationship between network interfaces on a single host,

including Open vSwitch bridges. To illustrate the complexity of

current Open vSwitch users, some of the more interesting setups seen

in the wild will be shown and described.

New OVS instrumentation features aimed at real-time monitoring

of virtual networks (Peter Phaal, InMon)

A Proposal for Using TC Classification with Open vSwitch

(Simon Horman, Netronome)

The traffic control (TC) framework of the Linux Kernel provides a

rich set of components for packet control and classification.

Recent work in TC with the eBPF classifier has highlighted the

richness of this framework and raises the question of how TC could

be leveraged to offload classification from Open vSwitch. In such a

model, TC could also serve as an abstraction layer where

classification could seamlessly be offloaded to other devices, such

as an intelligent NIC, through the use of eBPF. This presentation

will explore these offload opportunities and suggest ways in which

OVS may benefit from leveraging TC classification.

The State of Stateful Services (Joe Stringer and Jarno

Rajahalme, VMware)

Last year, we outlined plans to build out support for connection

tracking in OVS and described multiple potential users of this

functionality — ranging from stateful firewalling to NAT and

DPI. This talk provides an overview of what has been merged today,

and takes a look at the next steps for extending OVS stateful

service support.

Другие нюансы

Сетевая карта блейд-сервера должна быть совместима с модулями Virtual Connect

Совместимость можно проверить в QuickSpecs от HP.

Желательно обновлять Firmware модулей Virtual Connect до последней доступной версии, но делать это стоит очень осторожно, проверяя совместимость FW блейд-серверов и корзины.

В комплекте с модулями Virtual Connect SFP-трансиверы не идут, поэтому заранее планируйте схему физической коммутации, и покупайте правильные трансиверы.

Virtual Connect позволяет гарантировать и устанавливать ограничения пропускной способности для подсетей (на уровне vNet/Ethernet Network/VLAN). Этим стоит пользоваться, например, для ограничения VLAN-а с Management-трафиком ESXi до 1 Gbit и гарантии VLAN-у NFS-а от 4 Gbit до 10 Gbit.

libnx bindings

To use the bindings, you need to import the library .

import libnx

To initialize a structure, you can use the following syntax:

clkrstSession = libnx.ClkrstSession()

To access members of a structure, you can use the following syntax:

service = clkrstSession.s

To access a enumeration, you can use the following syntax:

libnx.PcvModuleId_CpuBus

To call a function, you can use the following syntax:

libnx.clkrstOpenSession(clkrstSession, libnx.PcvModuleId_CpuBus, 3)

Example use cases of this feature:

- Mounting game RomFS

- Creating save data on the system memory

- Opening a video in the web browser applet (with hardware acceleration)

- Opening the software keyboard applet

Постановка задачи

- Использование контроллера OpenFlow для запоминания MAC-адресов в режиме постобработки трафика. Каждое новое соединение сначала анализируется контроллером, который формирует для него разрешающие правила. Всякий раз, когда новый MAC-адрес появляется на порту или “переезжает” из одного порта в другой, контроллер должен изменить соответствующую таблицу правил коммутатора.

- “Обычное” (NORMAL) поведение. OpenFlow определяет такое поведение, как “работу обычного коммутатора без OpenFlow”. Если правило предусматривает такое поведение, то пакет проходит через коммутатор так, как будто на коммутаторе не настроен OpenFlow.

Подключение к LAN-play

Не в каждой игре есть возможность LAN-play. Актуальный список игр, которые поддерживают этот режим можно посмотреть здесь. В некоторых играх эта функция активируется специальной комбинацией клавиш. Более подробно об этом вы можете узнать в Discord

Так же не забывайте, что для успешного подключения все игроки должны иметь одинаковую версию игры и не всегда лучшей будет последняя. Уточняйте в чате на какой версии следует играть и где брать апдейт.

Настроим игру на примере Mario Kart 8

- Запустите игру

- Нажмите одновременно (L)+(R)+(Left_Analog)

- Зайдите в “Игра по LAN” и выберите “1и”, если собираетесь играть самостоятельно на своей приставке и “2и”, если на одной консоли будут играть два игрока

- Создайте комнату, или подключите к уже имеющейся

- Играйте

Flow Control

Modern network equipment and protocols handle port congestion better than those in the past. NFS and iSCSI as implemented in ESXi use TCP. TCP has built-in congestion management, making Ethernet flow control unnecessary. Furthermore, Ethernet flow control can actually introduce performance issues on other servers when a slow receiver sends a pause frame to storage and stops all traffic coming out of that port until the slow receiver sends a resume frame. Although NetApp has previously recommended flow control set to send on ESXi hosts and NetApp storage controllers, the current recommendation is to disable flow control on ESXi, NetApp storage, and on the switches ports connected to ESXi and NetApp storage.«ON» — all ports will advertise support for flow control (if autoneg), or flowcontrol turned on (non-autoneg).

«OFF» — all ports will advertise *no* support for flow control (if autoneg), or flowcontrol turned off (non-autoneg).

«Auto» — all uplink/stacking links will behave like «OFF», and all server links behave like «ON».NETAPP vs VMWARE FLOW CONTROL DILEMMAConfiguring Flow Control on VMware ESXi and VMware ESX

Debugging

The log for Ren’Py is recorded in the in the folder of the SD card root.

If a Python error occurs, the traceback will be recorded in the file in the of the SD card root.

If a native code error occurs, the elf file included in the SDK, which contains symbols, along with the crash report generated by Atmosphere (usually located in the folder in the folder of the SD card root), can be used to pinpoint the location of the error.

The following steps can be used to find the source file name, line, and function name of the native code error:

- In the generated crash report file, find the line(s) that contains

- Open GDB with the elf file by running the following:

- Make a note of the address such as (indicated by the number after the string(s) found in step 1)

- Enter the following in the GDB console: (where is the address noted in step 3)

Итак, что же мы получим в итоге?

- Расширяемое — это значит, что вам не придется перестраивать ваше облако при расширении. В любой момент вы сможете расширить ваше место в облаке, всего лишь добавив дополнительные жесткие диски в пул ceph. Еще вы можете без проблем сконфигурировать новую ноду и ввести ее в кластер при желании.

- Гибкое — девиз OpenNebula так и звучит «Flexible Enterprise Cloud Made Simple». OpenNebula очень простая в освоении и к тому же очень гибкая система. Вам не составит труда разобраться с ней, а так же при необходимости написать для нее свой модуль, т.к. вся система построена так, что бы быть максимально простой и модульной.

- Отказоустойчивое — В случае выхода из строя жесткого диска, кластер сам перестроится так, что бы обеспечить необходимое количество реплик ваших данных. В случае выхода из строя одной ноды, вы не потеряете управление, а облако продолжит функционировать до устранения вами проблемы.