Использование google analytics для отслеживания googlebot

Содержание:

- Зеркала сайтов

- Вопросы о файле robots.txt

- Нужно ли указывать директиву , чтобы разрешить сканирование?

- Что произойдет, если в файле robots.txt окажется ошибка или неподдерживаемая директива?

- В какой программе нужно создавать файл robots.txt?

- Если я с помощью директивы файла robots.txt заблокирую роботу Googlebot доступ к странице, исчезнет ли она из результатов поиска?

- Через какое время изменения в файле robots.txt отразятся на результатах поиска?

- Как полностью приостановить сканирование моего сайта на некоторое время?

- Мой сервер не учитывает регистр. Как полностью запретить сканирование некоторых папок?

- Googlebot and languages / locations

- What is a robots.txt file?

- Robots.txt questions

- I want to block a private folder. Can I prevent other people from reading my robots.txt file?

- Do I have to include an directive to allow crawling?

- What happens if I have a mistake in my robots.txt file or use an unsupported directive?

- What program should I use to create a robots.txt file?

- If I block Google from crawling a page using a robots.txt directive, will it disappear from search results?

- How long will it take for changes in my robots.txt file to affect my search results?

- How can I temporarily suspend all crawling of my website?

- My server is not case-sensitive. How can I disallow crawling of some folders completely?

- I use a site hosting service

- Директива Clean-param в robots.txt

- robots.txt의 제한사항 이해

- Проверка robots.txt (анализ, онлайн-валидатор)

- Заключение: советы Вебмастерам

Зеркала сайтов

Следующий вопрос, о котором хочется поговорить – это зеркала сайтов. Попробуем с ними разобраться. Как правило, любой сайт в интернете доступен по двум адресам: http://www.site.ru и http://site.ru. Для индексирующего робота это два изначально независимых ресурса, они индексируются независимо, и участвуют в поиске независимо друг от друга. Что это значит? Что у одного сайта может быть проиндексировано определенное количество страниц, они будут находиться по таким-то запросам. У второго сайта может быть совсем другая ситуация. И для того, чтобы избежать такого дублирования и перемешки, непонимания, мы используем зеркала сайтов.

Зачем все это нужно? Основная причина, по которой сейчас используются зеркала сайтов – это перенос сайта на новый адрес с сохранением характеристик старого адреса. Например, вы решили сменить доменное имя по каким-либо причинам. Потому что выбрали его 10 лет назад, и сейчас он кажется вам не современным, так как сложно писать пользователям, которые вбивают его в адресную строку, постоянно делают ошибки. Во-вторых, для того, чтобы предотвратить ошибочные переходы по другим адресам.

В первом случае, если мы совершаем переезд с использованием зеркал, мы сохраняем все характеристики старого сайта для нового. Соответственно, мы минимизируем какие-либо возможные проблемы.

Вопросы о файле robots.txt

Нужно ли указывать директиву , чтобы разрешить сканирование?

Нет. Сканирование будет выполняться и без директивы . Она нужна только для переопределения директивы в том же файле robots.txt.

Что произойдет, если в файле robots.txt окажется ошибка или неподдерживаемая директива?

Обычно поисковые роботы имеют достаточно гибкие алгоритмы, и незначительные ошибки в файле robots.txt никак не сказываются на их работе. В худшем случае неправильная или неподдерживаемая директива будет просто проигнорирована. Следует учесть, что при анализе файла robots.txt поисковый робот Google не сможет угадать, что имел в виду веб-мастер; он будет выполнять именно то, что написано в файле robots.txt. Вот почему рекомендуется исправить известные вам ошибки в этом файле. Как правило, это не представляет сложности.

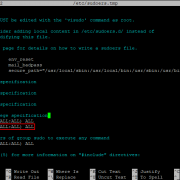

В какой программе нужно создавать файл robots.txt?

Используйте любую программу, позволяющую создавать текстовые файлы. Часто файлы robots.txt создаются в Блокноте, TextEdit, vi или Emacs. Более подробную информацию вы найдете в Справочном центре. Создав файл, проверьте его с помощью специального инструмента.

Если я с помощью директивы файла robots.txt заблокирую роботу Googlebot доступ к странице, исчезнет ли она из результатов поиска?

Если заблокировать роботу Googlebot доступ к странице, вероятно, она пропадет из индекса Google.

Однако даже при наличии директивы в файле robots.txt система Google может показать страницу в качестве подходящего результата поиска с учетом ссылок на нее с других ресурсов и прочей косвенной информации. Если вы хотите строго запретить индексирование страницы, используйте метатег robots со значением или HTTP-заголовок X-Robots-Tag. В этом случае не следует блокировать доступ к странице в файле robots.txt, поскольку робот Google должен просканировать ее, чтобы обнаружить тег и выполнить директиву.

Через какое время изменения в файле robots.txt отразятся на результатах поиска?

Прежде всего должна обновиться копия файла robots.txt в кеше (обычно Google кеширует содержание не более чем на один день). Процесс сканирования и индексирования является достаточно сложным, поэтому даже после того как изменения будут обнаружены, потребуется некоторое время для обновления информации. Для некоторых URL это может занять продолжительное время, вот почему невозможно назвать точные сроки. Следует также иметь в виду, что URL может отображаться в результатах поиска даже в том случае, если доступ к нему заблокирован в файле robots.txt и Google не может его просканировать. Если вы хотите запросить удаление заблокированных страниц из результатов поиска Google, отправьте запрос с помощью Search Console.

Как полностью приостановить сканирование моего сайта на некоторое время?

Для временной приостановки сканирования всех URL следует отобразить для них код ответа HTTP 503 (в том числе и для файла robots.txt). Робот Google будет периодически пытаться получить доступ к файлу robots.txt до тех пор, пока он не станет вновь доступен. Не рекомендуется запрещать сканирование путем внесения изменений в файл robots.txt.

Мой сервер не учитывает регистр. Как полностью запретить сканирование некоторых папок?

Директивы в файле robots.txt зависят от регистра. В таком случае рекомендуется с помощью методов канонизации убедиться, что индексируется только одна версия URL. Это позволит упростить файл robots.txt. Если такой вариант невозможен, рекомендуем перечислить основные комбинации названия папки или максимально сократить его, оставив только несколько начальных символов вместо полного названия. Например, не нужно перечислять все возможные комбинации из строчных и прописных букв для «/MyPrivateFolder». Вместо этого можно просто указать варианты для «/MyP» (если вы уверены, что не существует других URL с теми же начальными символами, но которые следует сканировать). Если проблема заключается не в сканировании, можно указать метатег robots или HTTP-заголовок X-Robots-Tag.

Googlebot and languages / locations

If your pages show different languages or content depending on the location or language of the request, Googlebot may not always see all your content (they recommend using hreflang).

But this article is about Googlebot, and what Googlebot has started doing for language and location based content is interesting.

Let’s take a look…

When users are visiting your page and you have a location or language based solution for different content then a user in Italy will see the Italian content and a user in America will see English content.

Googlebot is based in America, so how does that work? How will Googlebot see that Italian content?

What is a robots.txt file?

The robots.txt file controls how search engine spiders like Googlebot see and interact with your webpages.

In short, a robots.txt file tells Googlebot what to do when it visits your pages by listing files and folders that you do not want Googlebot to access.

Learn more about it in my guide to the robots.txt file.

To see your robots.txt file (or to see if you have one) you can enter a url (your homepage for example) in the tool below and it will show you it right here on this page.

Here are a few resources from Google that speak of robot instructions:

- robots.txt file

- Technical overview of how Google handles robots.txt

- Robots meta tags and headers

Robots.txt questions

I want to block a private folder. Can I prevent other people from reading my robots.txt file?

No. The robots.txt file may be read by various users. If folders or filenames of content should not be public, they should not be listed in the robots.txt file. It is not recommended to serve different robots.txt files based on the user-agent or other attributes.

Do I have to include an directive to allow crawling?

What happens if I have a mistake in my robots.txt file or use an unsupported directive?

Web-crawlers are generally very flexible and typically will not be swayed by minor mistakes in the robots.txt file. In general, the worst that can happen is that incorrect / unsupported directives will be ignored. Bear in mind though that Google can’t read minds when interpreting a robots.txt file; we have to interpret the robots.txt file we fetched. That said, if you are aware of problems in your robots.txt file, they’re usually easy to fix.

What program should I use to create a robots.txt file?

You can use anything that creates a valid text file. Common programs used to create robots.txt files are Notepad, TextEdit, vi, or emacs. Read more about creating robots.txt files. After creating your file, validate it using the robots.txt tester.

If I block Google from crawling a page using a robots.txt directive, will it disappear from search results?

Blocking Google from crawling a page is likely to remove the page from Google’s index.

However, robots.txt does not guarantee that a page will not appear in results: Google may still decide, based on external information such as incoming links, that it is relevant. If you wish to explicitly block a page from being indexed, you should instead use the robots meta tag or X-Robots-Tag HTTP header. In this case, you should not disallow the page in robots.txt, because the page must be crawled in order for the tag to be seen and obeyed.

How long will it take for changes in my robots.txt file to affect my search results?

First, the cache of the robots.txt file must be refreshed (we generally cache the contents for up to one day). Even after finding the change, crawling and indexing is a complicated process that can sometimes take quite some time for individual URLs, so it’s impossible to give an exact timeline. Also, keep in mind that even if your robots.txt file is disallowing access to a URL, that URL may remain visible in search results despite that fact that we can’t crawl it. If you wish to expedite removal of the pages you’ve blocked from Google, please submit a removal request via Google Search Console.

How can I temporarily suspend all crawling of my website?

You can temporarily suspend all crawling by returning a HTTP result code of 503 for all URLs, including the robots.txt file. The robots.txt file will be retried periodically until it can be accessed again. We do not recommend changing your robots.txt file to disallow crawling.

My server is not case-sensitive. How can I disallow crawling of some folders completely?

Directives in the robots.txt file are case-sensitive. In this case, it is recommended to make sure that only one version of the URL is indexed using canonicalization methods. Doing this allows you to simplify your robots.txt file. Should this not be possible, we recommended that you list the common combinations of the folder name, or to shorten it as much as possible, using only the first few characters instead of the full name. For instance, instead of listing all upper and lower-case permutations of «/MyPrivateFolder», you could list the permutations of «/MyP» (if you are certain that no other, crawlable URLs exist with those first characters). Alternately, it may make sense to use a robots meta tag or X-Robots-Tag HTTP header instead, if crawling is not an issue.

I use a site hosting service

If you use a website hosting service, such as Wix, Drupal, or Blogger, you might not need to (or be able to) edit your robots.txt file directly. Instead, your provider might expose a search settings page or some other mechanism to tell search engines whether or not to crawl your page.

To see if your page has been crawled by Google, search for the page URL in Google.

If you want to hide (or unhide) your page from search engines, add (or remove) any page login requirements that might exist, and search for instructions about modifying your page visibility in search engines on your hosting service, for example: wix hide page from search engines

Директива Clean-param в robots.txt

Чтобы поисковые роботы не обходили данные страницы, и лишний раз не нагружали ваш сервер, используйте директиву Clean-param, которая позволит оставить в выдаче только исходный документ.

https://naked-seo.ru/books/get_book.pl?userID=1&source=site_1&book_id=3 https://naked-seo.ru/books/get_book.pl?userID=2&source=site_2&book_id=3 https://naked-seo.ru/books/get_book.pl?userID=3&source=site_3&book_id=3

Параметр userID, который содержится в каждом url-адресе показывает персональный идентификатор пользователя, а параметр source показывает источник, из которого посетитель попал к нам на сайт. По трем разным url-адресам пользователи видят один и тот же контент book_id=3. В данном случае нам необходимо использовать директиву Clean-param следующим образом:

User-agent: Yandex Clean-param: userID /books/get_book.pl Clean-param: source /books/get_book.pl

Данные директивы помогут поисковому роботу Яндекса свести все динамические параметры в единую страницу:

https://naked-seo.ru/books/get_book.pl?&book_id=3

Если на сайте доступна такая страница, то именно она будет индексироваться и участвовать в выдаче.

robots.txt의 제한사항 이해

를 작성하거나 수정하기 전에 이 URL 차단 방법의 제한사항에 관해 알아야 합니다. 경우에 따라 웹에서 내 URL이 검색되지 않도록 하는 다른 메커니즘을 고려해볼 수도 있습니다.

- Robots.txt 명령어는 일부 검색엔진에서만 지원될 수 있습니다. 파일의 지침은 사이트에서의 크롤러 동작을 강제로 제어할 수 없습니다. 크롤러가 스스로 지침을 준수할지를 판단하게 됩니다. Googlebot 및 기타 잘 제작된 웹 크롤러는 파일의 지침을 준수하지만 그렇지 않은 크롤러도 있습니다. 그러므로 정보를 웹 크롤러로부터 안전하게 보호하려면 서버에서 비공개 파일을 비밀번호로 보호하는 등 다른 차단 방법을 사용하는 것이 좋습니다.

-

크롤러마다 구문을 다르게 해석합니다.

잘 제작된 웹 크롤러는 파일의 지침을 따르지만 크롤러마다 지침을 다르게 해석할 수도 있습니다. 특정 지침을 이해하지 못하는 크롤러도 있으므로 다양한 웹 크롤러에 적용될 수 있는 적절한 구문을 알아야 합니다. -

다른 사이트에서 연결된 경우 robots.txt 파일을 사용한 페이지의 색인이 생성될 수도 있습니다.

Google은 를 통해 차단된 콘텐츠를 크롤링하거나 콘텐츠의 색인을 생성하지 않지만, 허용되지 않은 URL이 웹상의 다른 곳에 연결된 경우 관련 정보를 찾아 색인을 생성할 수는 있습니다. 결과적으로 URL 주소뿐만 아니라 페이지 링크의 앵커 텍스트와 같은 기타 공개 정보가 Google 검색결과에 표시될 수 있습니다. URL이 Google 검색결과에 표시되지 않게 하려면 서버의 파일을 비밀번호로 보호하거나 noindex 메타 태그 또는 응답 헤더를 사용하세요. 또는 페이지를 아예 삭제할 수도 있습니다.

참고: 여러 크롤링 및 색인 생성 지침을 함께 사용할 경우 일부 지침이 다른 지침과 충돌할 수 있습니다. 지침을 제대로 구성하는 방법을 알아보려면 Google Developers 설명서의 을 참조하세요.

Проверка robots.txt (анализ, онлайн-валидатор)

Инструменты проверки файла robots.txt есть как у Гугла, так и у Яндекса. Их можно найти в Google Search Console и в Яндекс.Вебмастере. Помимо того, что эти инструменты покажут сразу количество ошибок (если таковые будут), они еще дают возможность вводить конкретный URL-адрес и проверять, доступна ли страница по этому адресу для индексации поисковыми роботами или нет. Это полезно, когда в robot.txt прописано большое количество правил и есть опасение, что некоторые из них могут друг с другом конфликтовать.

Также существуют и сторонние сервисы проверки файла robots.txt, но обычно штатных инструментов более чем достаточно. Тут хочу сразу оговорится, что если вы никогда не писали правил и слабо себе представляете что нужно закрывать от индексации, а что обязательно нужно оставлять открытым, то лучше обратиться к специалистам, которые учтут все моменты связанные с вашим конкретно взятым сайтом.

Заключение: советы Вебмастерам

Совет #1

Если ваш сайт не индексируется поисковыми системами, или его страницы начали массово пропадать из поисковой выдачи, первым делом необходимо проверить файл robots.txt на предмет запрета индексации сайта. При необходимости снимите запрет на полезные страницы, которые должны участвовать в выдаче.

Если файл robots.txt не запрещает индексирование сайта, проверьте содержимое мета-тегов в head вашего сайта, адресованных поисковым роботам

Обратите внимание на наличие на вашем сайте следующих тегов:

<meta name="robots" content="noindex"/> — запрещает индексировать содержимое страницы <meta name="robots" content="nofollow"/> — запрещает переходить по ссылкам на странице <meta name="robots" content="none"/> — запрещает переходить по ссылкам и индексировать содержимое страницы <meta name="robots" content="noindex, nofollow"/> — аналогичен предыдущему тегу

Наличие данных тегов может негативно повлиять на представление вашего сайта в поисковых системах.

Совет #2

Хотя бы 1 раз в 2-3 недели заглядывайте в Яндекс Вебмастер в разделы «Индексирование — Статистика обхода» и «Индексирование — Страницы в поиске». Отслеживайте страницы, которые обходит поисковый робот на вашем сайте.

Если робот обходит технические страницы, или страницы, которые отвечают редиректом, их следуют запретить директивой Disallow в robots.txt. Таким образом вы сузите объем страниц, который необходимо обойти поисковому роботу и повысите эффективность индексации своего сайта.

Аналогична ситуация с разделом «Страницы в поиске». С его помощью вы можете не только отследить документы, которые больше не участвуют в поиске, но и проверить свой сайт на предмет наличия поискового спама. Если в данном разделе вы также найдете технические страниц, либо сервисные страницы с параметрами, которые не должны принимать участие в ранжировании, добавьте запрет на их обход в robots.txt.

Заключение

Файл robots.txt является одним из важнейших инструментов SEO-оптимизации. Через него можно напрямую влиять на индексирование абсолютно любых страниц и разделов сайта. Грамотно составленный robots.txt поможет вам сэкономить место в ограниченном краулинговом бюджете, избавит поисковые роботы от переобхода сотен ненужных технических страниц, избавит выдачу от поискового спама, а ваш сервер от излишней нагрузки. Создавайте robots.txt с умом!